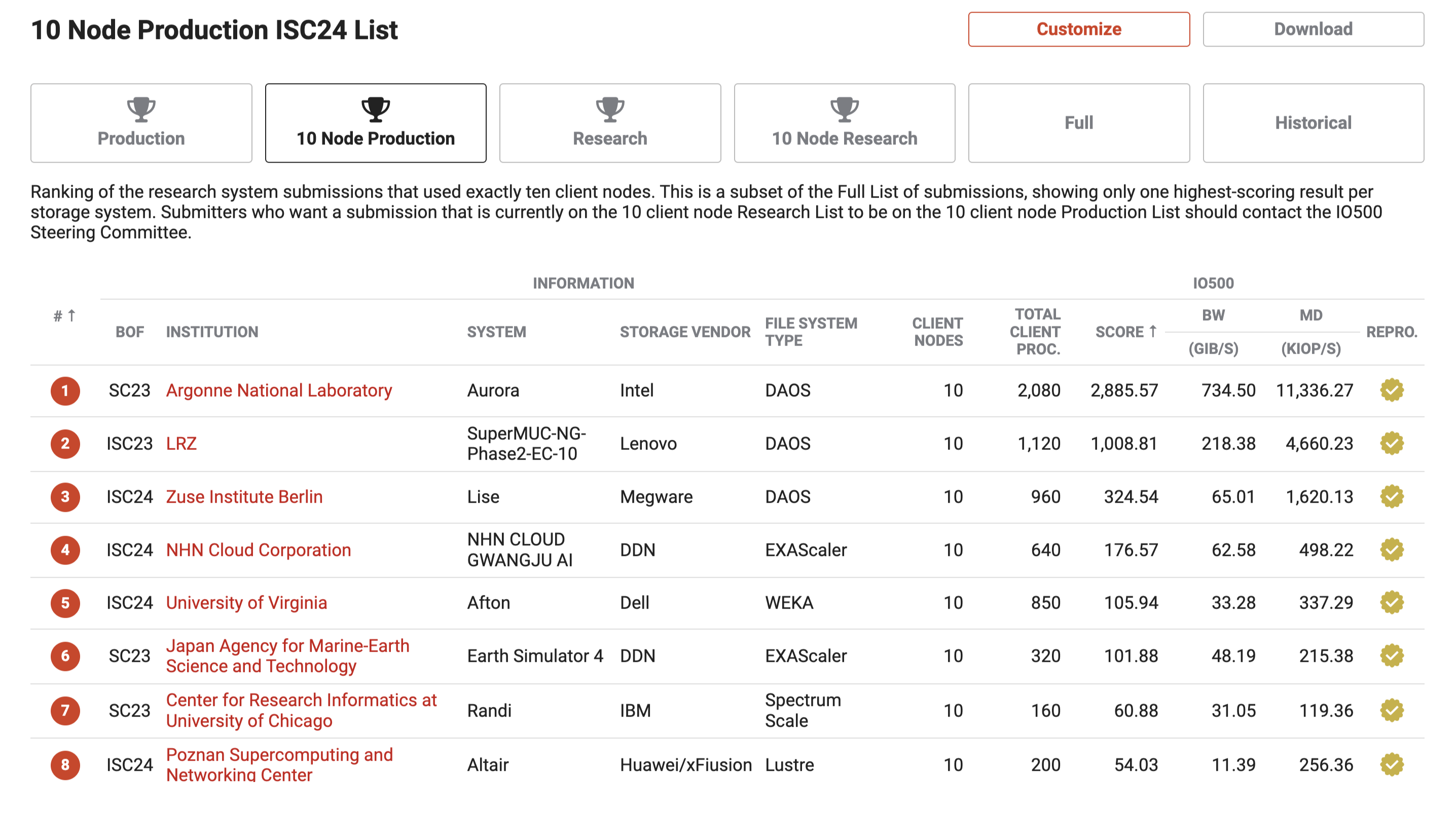

System przechowywania danych dla HPC w Poznańskim Centrum Superkomputerowo-Sieciowym znalazł się ponownie na wysokiej pozycji w prestiżowym konkursie IO500, organizowanym podczas konferencji ISC High Performance 2024. System zajął 8. miejsce w kategorii “10 Node Production List”, w której notowany jest po raz pierwszy oraz 14. miejsce w kategorii “Production List”, w której system PCSS jest obecny od 2023 r.

Eksplozja zastosowań Big Data, Data Science i AI powoduje, że systemy IT a w szczególności systemy obliczeniowe HPC oraz systemy chmurowe, których budowa i utrzymanie stanowią trzon działania PCSS, potrzebują coraz szybszego dostępu do danych, używają coraz obszerniejszych zbiorów danych i coraz większej liczby plików. Efektywność dostępu do danych jest więc kluczem do wydajności obliczeń i analizy danych oraz postępów w badaniach, edukacji i gospodarce opartych na danych.

W trakcie największej konferencji HPC w Europie – ISC High Performance (13-16 maja 2024 r.) ogłoszone zostały listy TOP500 i Green500 – będące zestawieniem najszybszych i najbardziej efektywnych energetycznie komputerów HPC na świecie, a także lista I500 – która porównuje najszybsze systemy przechowywania danych dla systemów HPC i centrów danych.

System przechowywania danych dla HPC w PCSS znalazł się ponownie na wysokich pozycjach w konkursie IO500, zajmując 8. miejsce w kategorii “10 Node Production List”, w której notowany jest po raz pierwszy oraz 14. miejsce w kategorii “Production List”, w której jest obecny od listopada 2023.

Miejsca systemów PCSS plasują nas wśród najszybszych produkcyjnych rozwiązań akademickich i komercyjnych obok wysoko sklasyfikowanych partnerów europejskich, w tym LRZ, CINECA i UCL.

W rankingu “10 Node Production List” system PCSS jest najwyżej notowanym systemem opartym o otwarte oprogramowanie Lustre, które – co warto podkreślić – nawiązuje walkę z rozwiązaniami zamkniętymi (appliance) największych producentów systemów przechowywania danych w tym: DDN Exascaler, Intel DAOS, IBM Spectrum Scale czy WekaIO.

Pozycja systemu PCSS jest tym większym sukcesem, że architektura systemu i jego konfiguracja zostały w całości określone i zoptymalizowane przez architektów systemów przechowywania danych w PCSS. W opracowaniu konfiguracji produkcyjnej i benchmarkowej systemu wykorzystaliśmy wiedzę i doświadczenie dotyczące skalowalności i wydajności systemów przetwarzania danych gromadzone w ramach wieloletniego utrzymania systemów i świadczenia usług zarządzania danymi w Pionie Przetwarzania Danych PCSS.

Innym godnym podkreślenia faktem jest, iż w kategorii “10 Node Production List” rankingu IO500 zestawiana jest wydajność systemów dla określonej, maksymalnej liczby węzłów klienckich, co pozwala wiarygodnie porównywać wydajność systemów o podobnej wielkości. Takie zestawienie w szczególny sposób promuje i punktuje są systemy, które w ramach skali określonej z góry zasadami konkursu zostały odpowiednio zaprojektowane i zoptymalizowane. Również w tym aspekcie należy podkreślić sukces PCSS, który w architekturze otwartej systemu był w stanie zbudować system o wydajności porównywalnej do najszybszych, wysoko zoptymalizowanych systemów vendorskich.

Informacje techniczne

System zgłoszony do konkursu IO500 jest oparty na otwartym oprogramowaniu Lustre w wersji 2.15.3 oraz platformie serwerowej i macierzowej xFusion/Huawei pozyskanych a także przełącznikach sieci Infiniband (Mellanox/nVidia) pozyskanych przez PCSS w 2023.

W obecnej edycji konkursu IO500 dzięki m.in. zastosowaniu sieci nowej generacji InfiniBand o przepustowości 200GBit/s uzyskaliśmy bardzo wysoką pozycję 8. w kategorii “10 Node Production List”.

Innym kluczowym aspektem konfiguracji systemu w PCSS jest szerokie zastosowanie pamięci flash, dla zapewnienia dużej wydajności operacji na meta-danych i na samych danych. Dla meta-danych systemu Lustre stosujemy macierze full-flash, co zapewnia efektywną realizację operacji na plikach, listowanie katalogów, dostęp do atrybutów plików itp., natomiast dla danych systemu – macierze dyskowe z akceleracją na pamięciach flash, co przyspiesza dostęp do wielu plików i bloków danych.

Podsumowanie

System przechowywania danych dla HPC został pozyskany i wdrożony przez PCSS w ramach projektów Krajowy Magazynu Danych (KMD) oraz PRACE-LAB i PRACE-LAB2. W ramach projektu KMD w 9 lokalizacjach udostępniane jest blisko 700 PBajtów przestrzeni przechowywania danych na pamięciach flash i dyskowych, w systemach plikowych i obiektowych oraz na systemach taśmowych. W ramach projektów PRACE-LAB i PRACE-LAB2 (Współpraca w Zakresie Zaawansowanych obliczeń w Europie) zaprojektowano i wdrożono systemy obliczeniowe HPC oparte o platformy CPU i GPU w 5 lokalizacjach w Polsce wraz z specjalizowanymi systemami przechowywania danych o dużej wydajności.

PCSS był koordynatorem tych projektów, realizowanych we współpracy z 8 partnerami włączając centra KDM i ośrodki MAN w Polsce: Narodowe Centrum Badań Jądrowych (NCBJ), Politechnikę Gdańską (CI TASK), Politechnikę Wrocławską – Wrocławskie Centrum Sieciowo-Superkomputerowe (WCSS), Akademickie Centrum Komputerowe CYFRONET AGH, Politechnikę Białostocką, Politechnikę Częstochowską, Politechnikę Świętokrzyską i Politechnikę Łódzką.

Więcej informacji:

● Zestawienie IO 500 10 Node Production ISC24 List,

● Zestawienie IO 500 Production ISC24 List.